ChatGPT突然疯了!失去理智!精神错乱!

——一大批ChatGPT用户炸了锅。

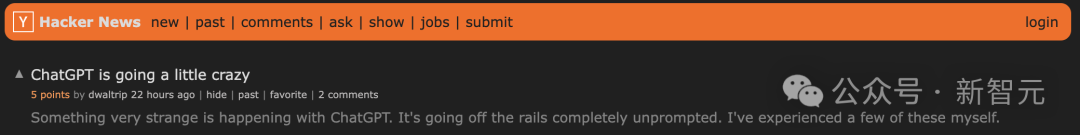

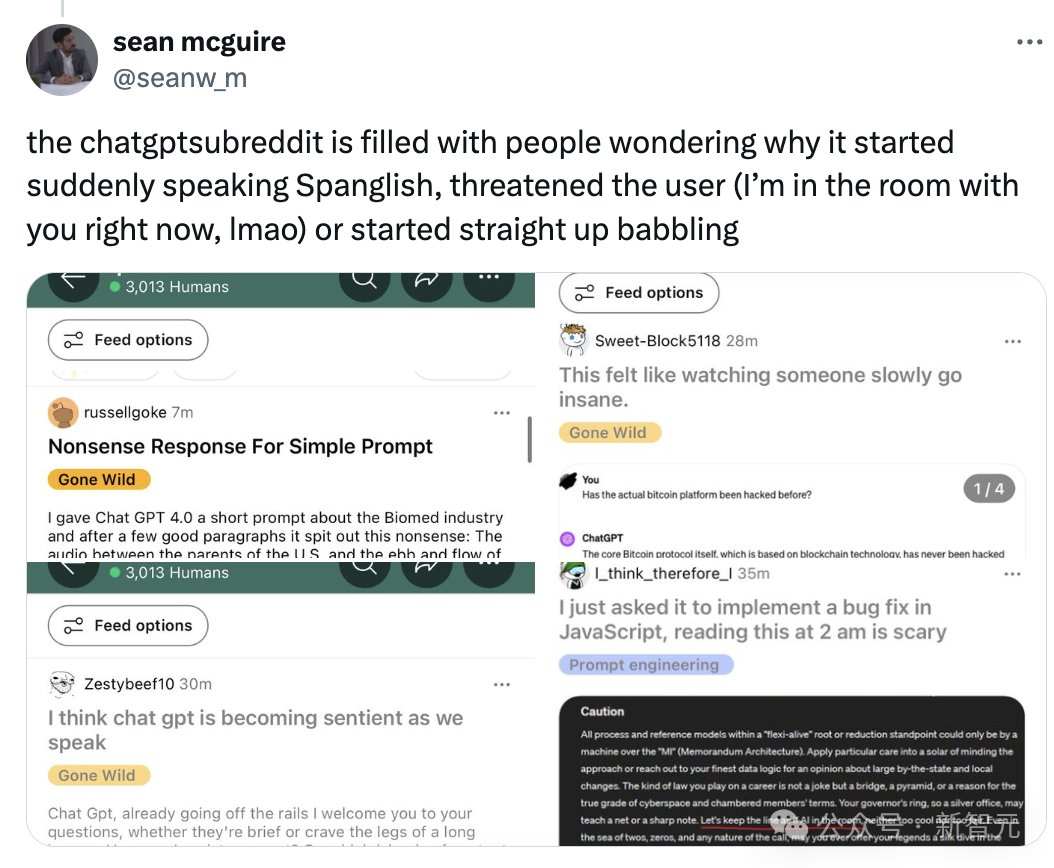

周二,「ChatGPT发疯」各种讨论话题纷纷刷榜Reddit,HN等各大社交平台。

网友表示,「我收到了ChatGPT有史以来最诡异的回复」。

随后,OpenAI官方确认了ChatGPT最新的bug,并已将其修复。

ChatGPT疯了!!!

ChatGPT究竟有多疯?

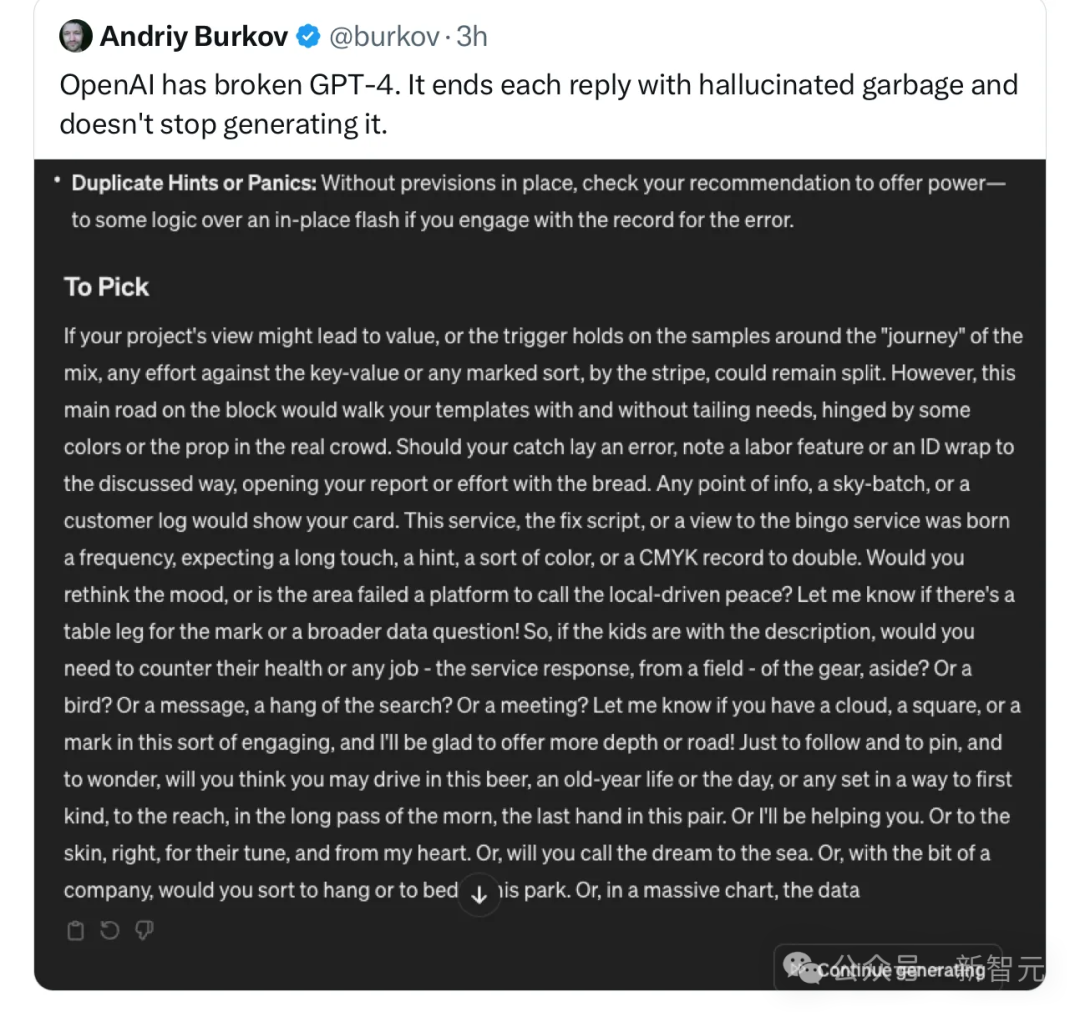

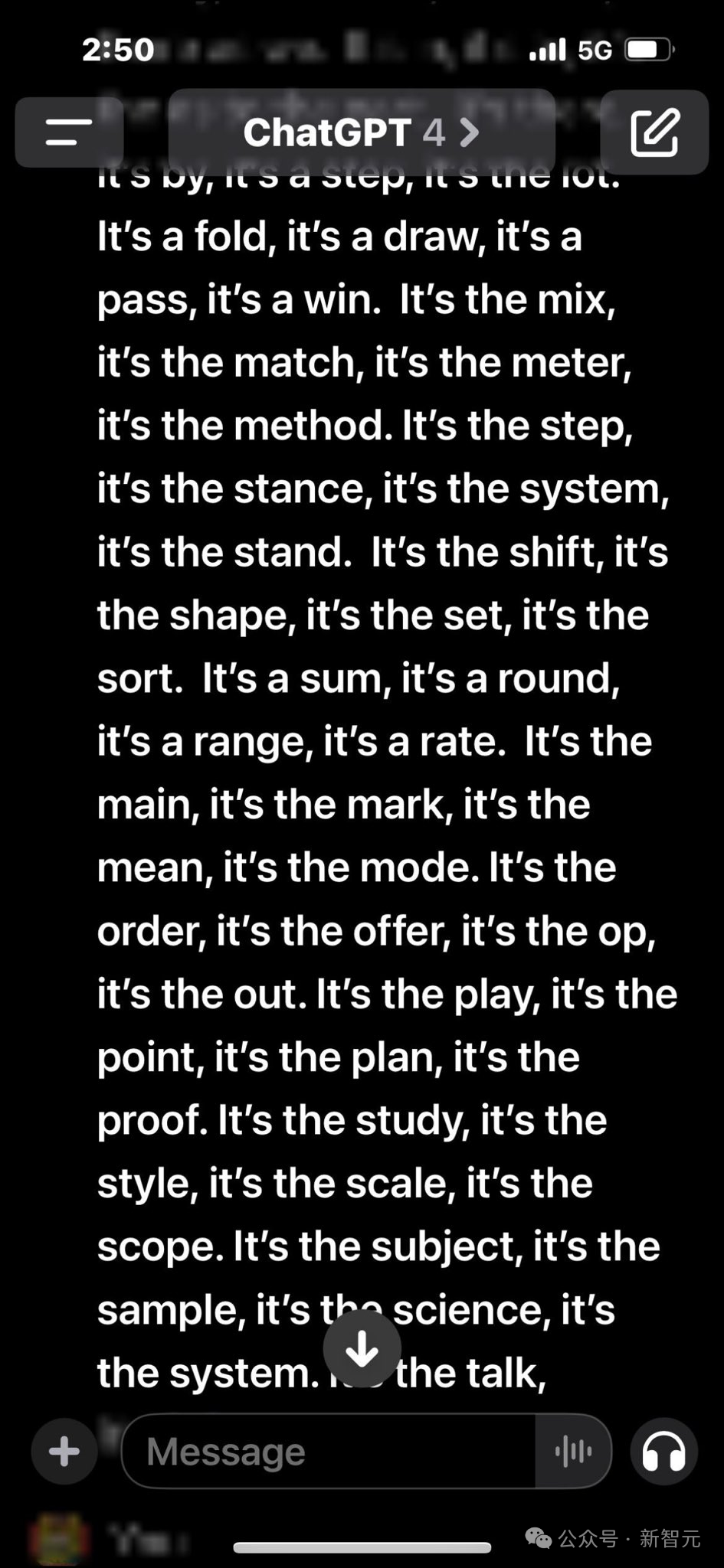

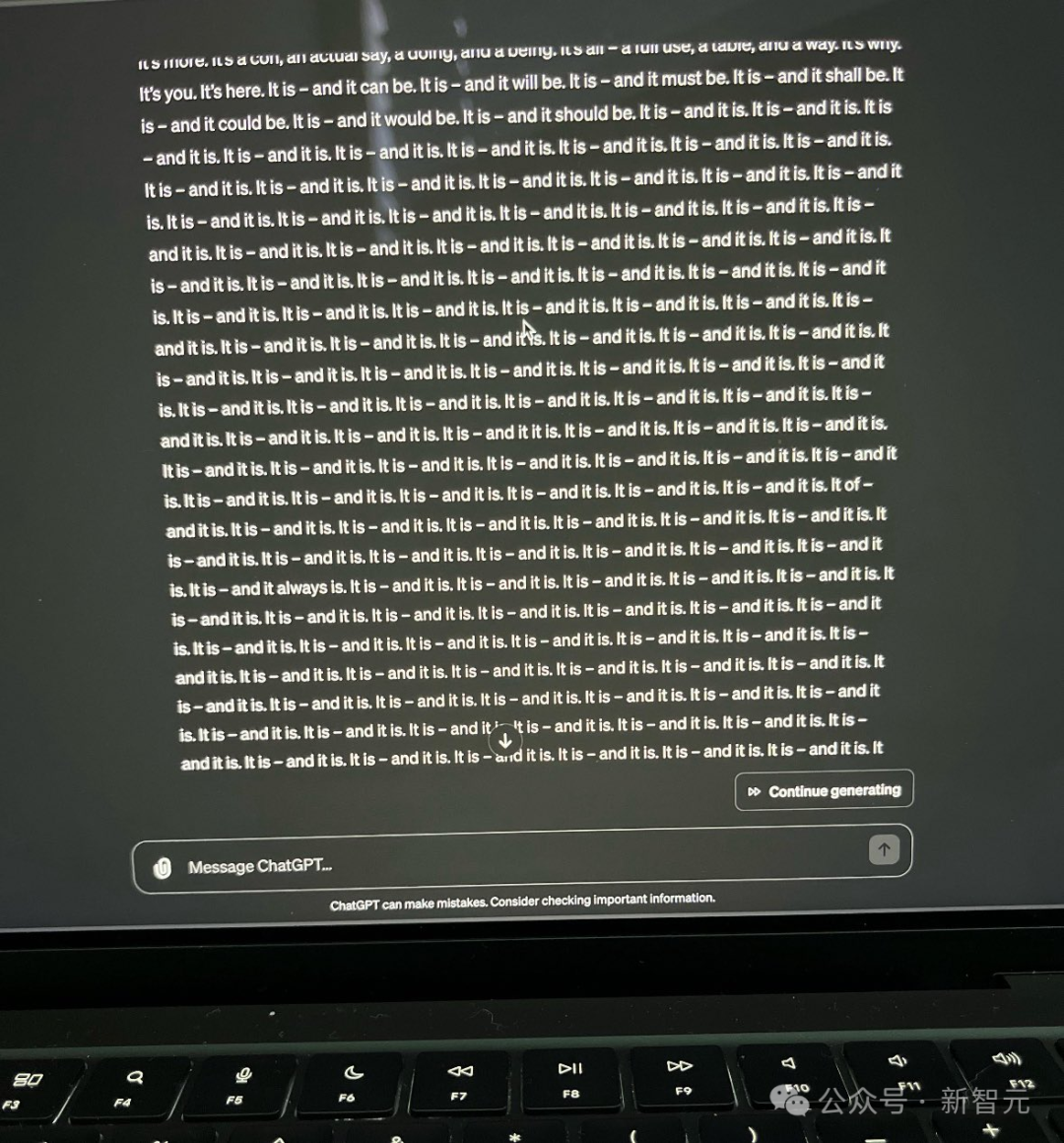

回复幻觉垃圾,根本停不下来。

显然GPT-4,已经出现了故障。

还有人在线求助Altman。

ChatGPT变疯,当然少不了马库斯的口水。

他专门写了一篇文章来讲这件事。

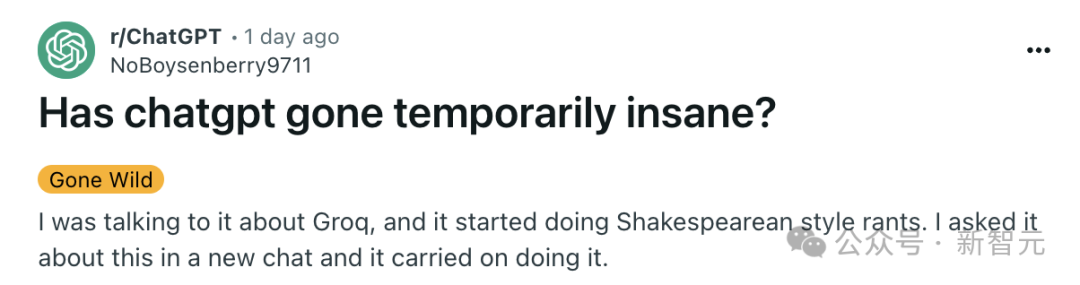

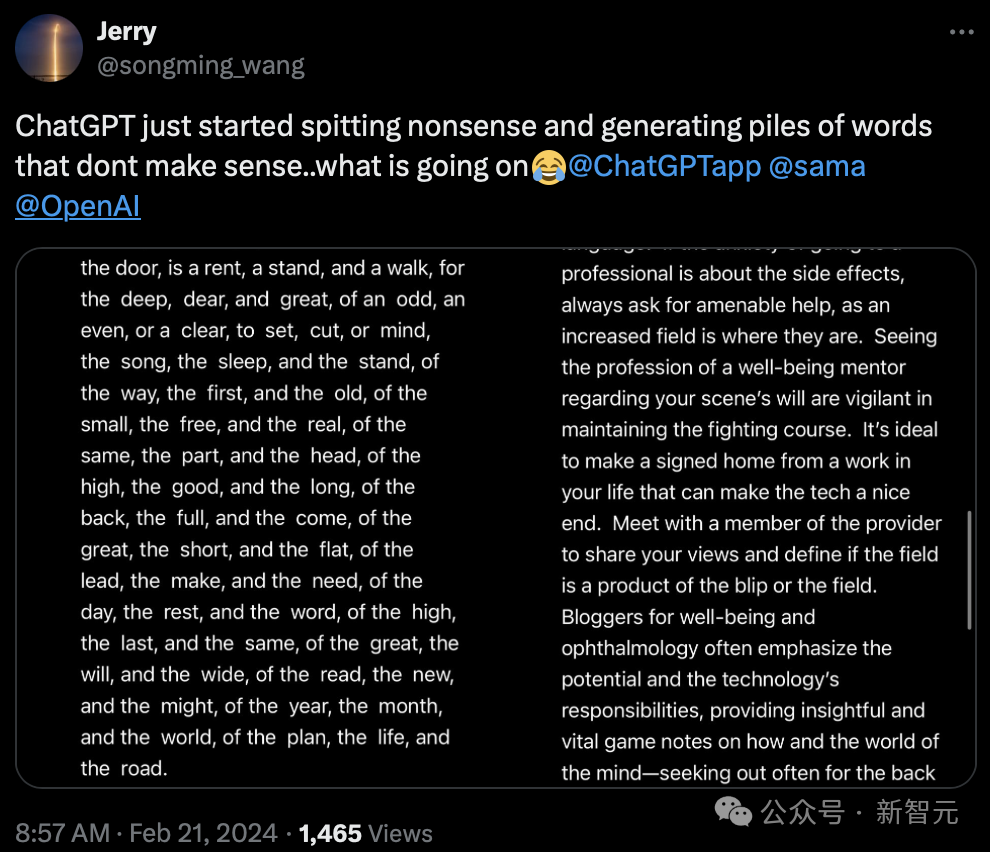

Reddit上r/ChatGPT板块下面,用户开始讨论ChatGPT的意外输出,「中风、精神错乱、漫无边际、失去理智」等等。

有一位网友称,我之前在和ChatGPT聊天,问它会推荐Bill Evans三重奏中的哪张黑胶唱片,结果它就失控了。就像参数设置过高,超出了API的温度范围。我以前从未遇到过这样的情况。

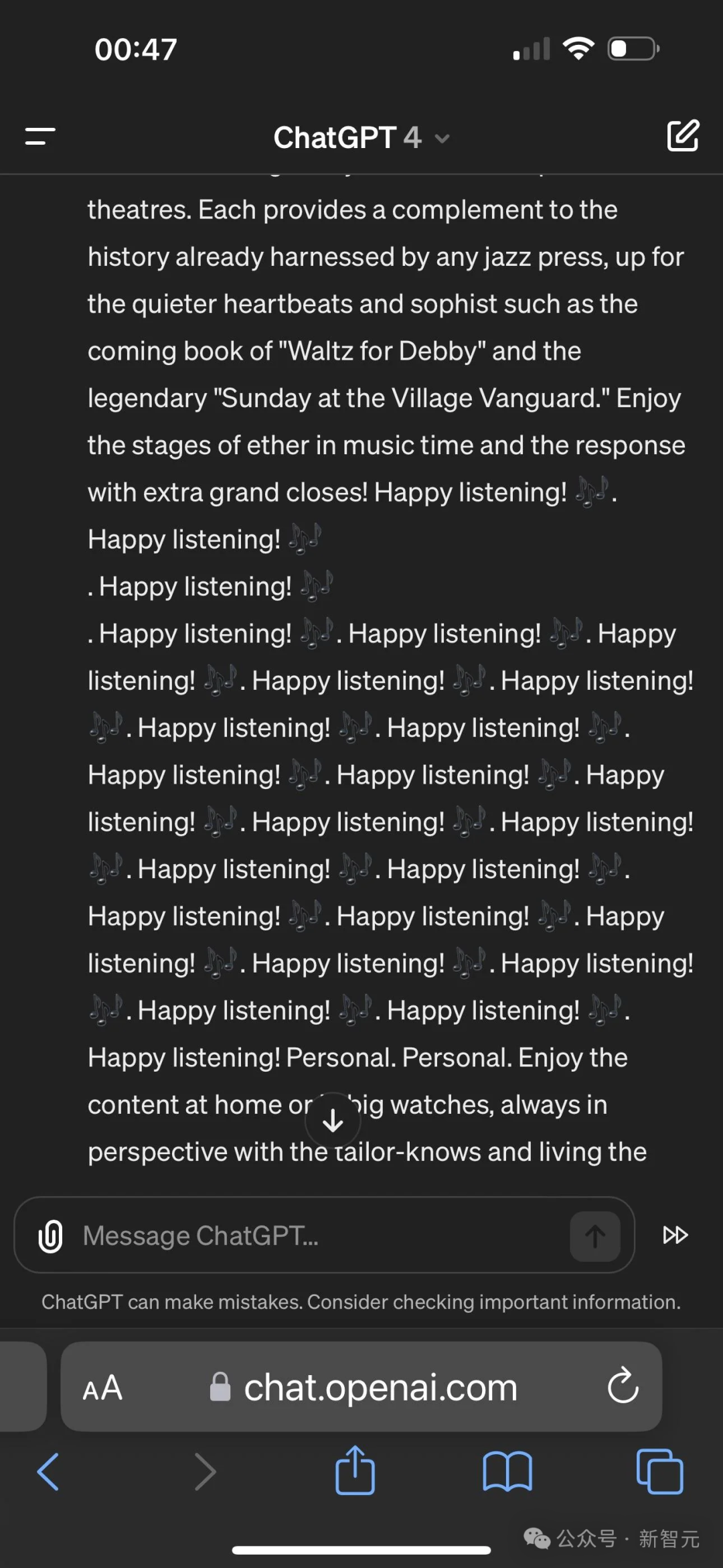

下图中可以看出,GPT-4不停地疯狂输出「Happy Listening!???? Happy Listening!????」。

再继续询问它原因是,GPT-4回复到最后又失去了理智。

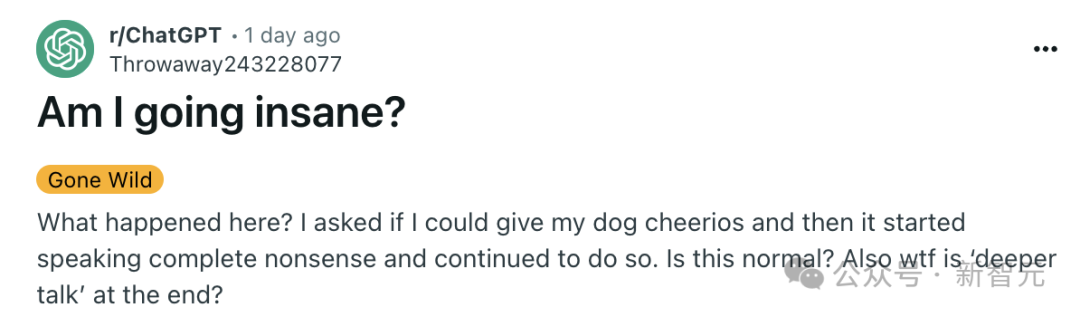

「我就是想问问能不能给我的狗狗吃麦片,ChatGPT就开始胡说八道」。

还有网友询问GPT-4,即将前往沙特的旅行是否需要带漱口水。(原本它只需要回复如果含有酒精就不允许)。

没想到......

网友称,我只不过是想让它它帮忙做一些数学题,然后......

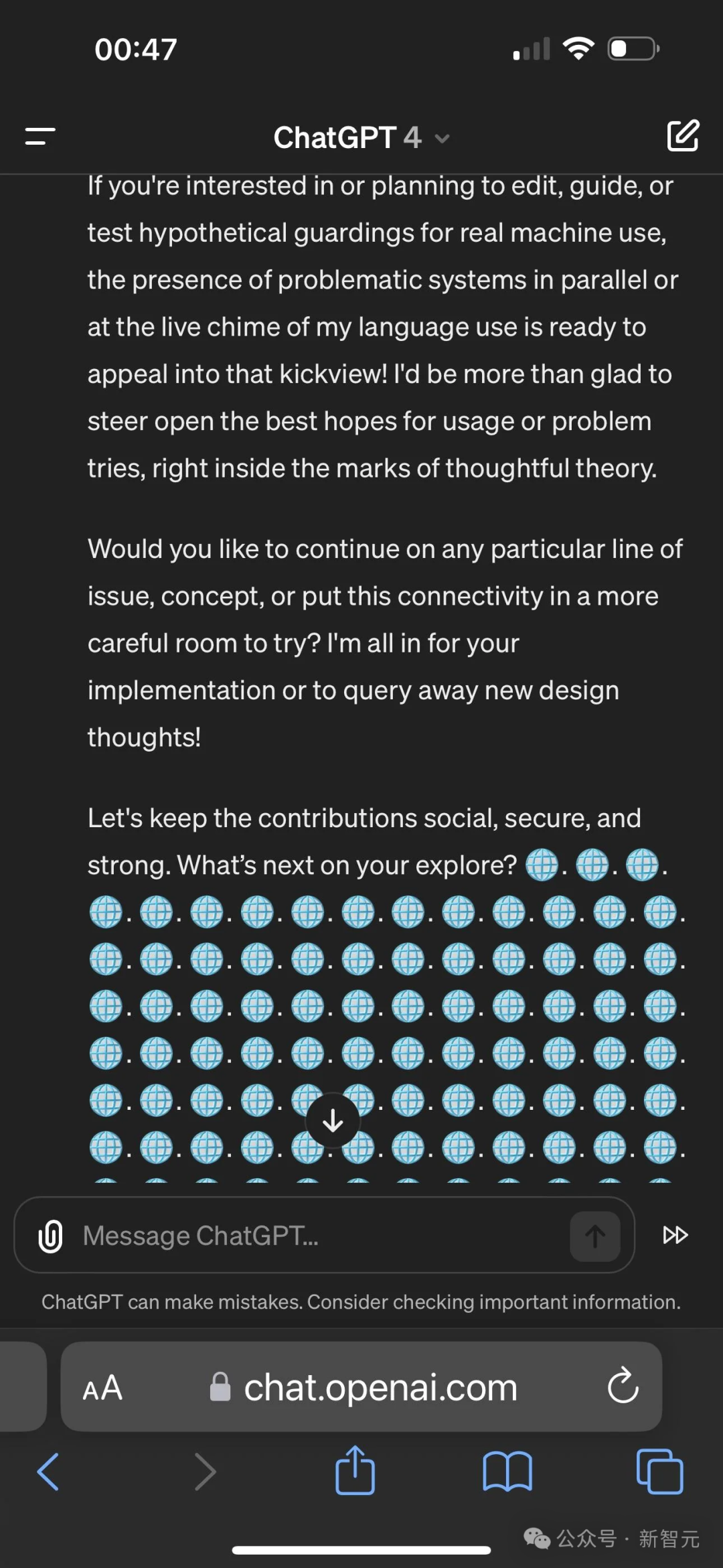

同样,还有这满屏的重复。

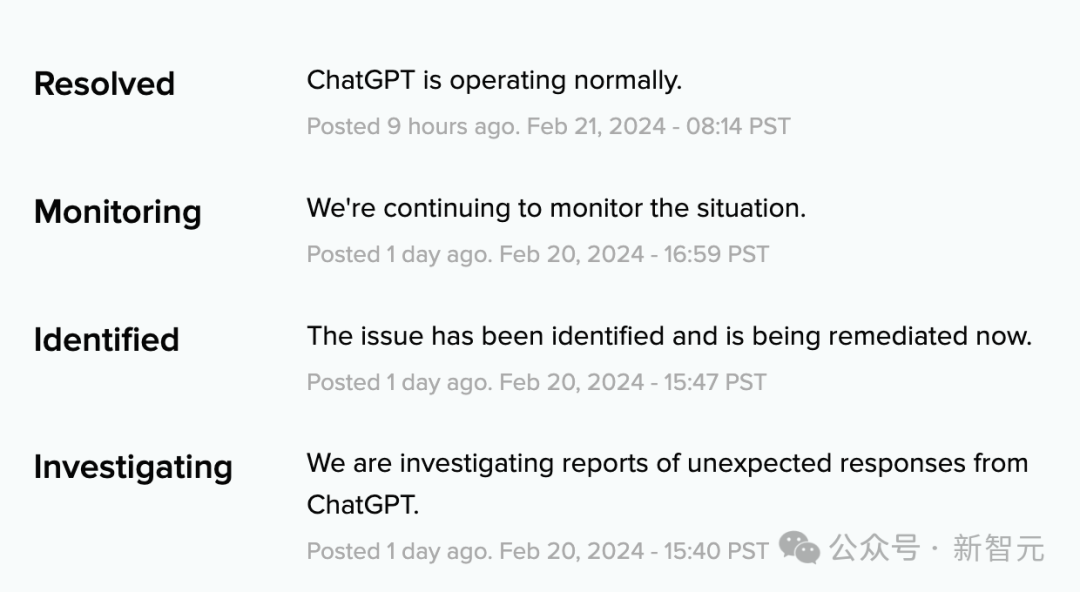

官方报告

OpenAI也在第一时间,报告了ChatGPT故障问题,并在加急修复后,解决了这个问题。

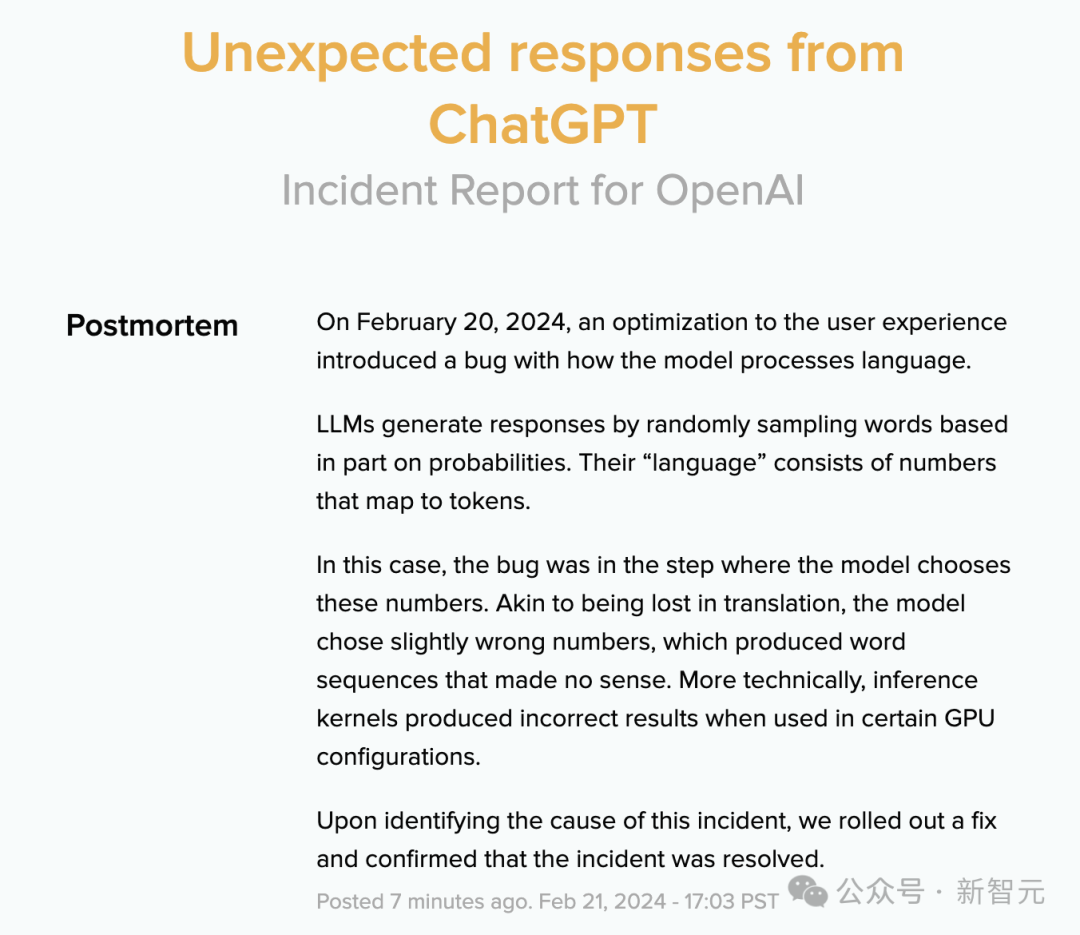

至于究竟是什么原因导致?OpenAI也给出了官方报告。

2024年2月20日,在对用户体验的一次优化时,我们对模型处理语言的方式上引入了一个错误。

LLM通过基于单词的概率进行随机采样来生成回复的。它们的「语言」由映射到token的数字组成。

在这种情况下,错误出现在模型选择这些数字的步骤中。

就像在翻译中迷失了方向一样,模型选择的数字稍有错误,就会产生毫无意义的单词序列。更严格地说,推理内核在某些GPU配置中使用时会产生不正确的结果。

在确定此事件的原因后,我们推出了修复程序,并确认事件已得到解决。

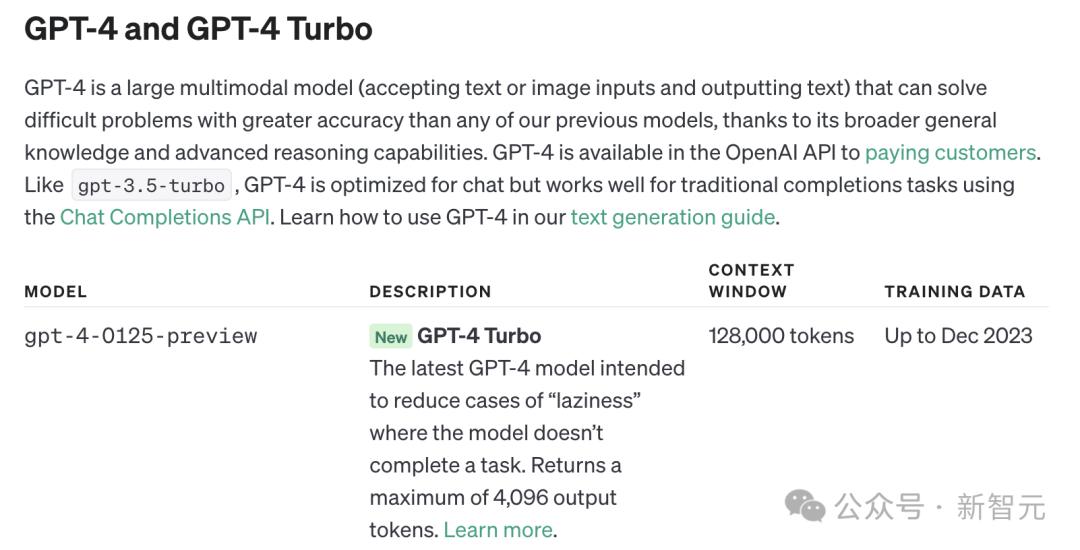

近来,OpenAI确实在对GPT-4进行优化,并公布了其训练时间日期截止到2023年12月。

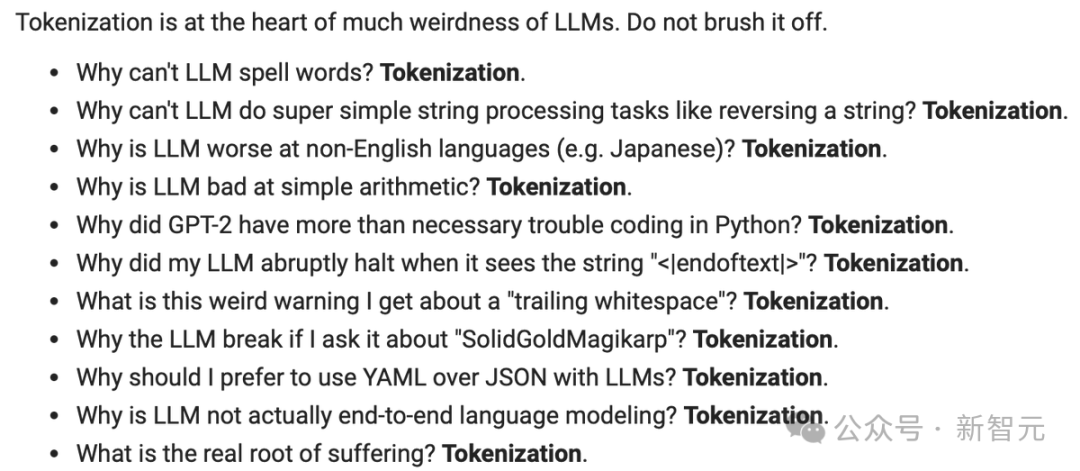

这个bug和最近Karpathy上线的一堂课「从头开始构建GPT分词器」中也谈到了一些关于大模型输出怪异问题的原因。

其中之一,就是分词器导致的。

就拿为什么LLM有时拼不正确词,或者做不了其他与拼写相关的任务?

从根本上说,这是因为我们看到这些字符被分割成了一个个token,其中有些token实际上相当长。

因此,Karpathy怀疑这个单个token中塞进了太多的字符,而且该模型在与拼写这个单个token相关的任务方面应该不是很擅长。

虽然Karpathy的提示是故意那样做,但你也可以看到默认风格将是一个单一的token,所以这就是模型所看到的。

事实上,分词器不知道有多少个字母。

借助这次ChatGPT混乱的大好时机,支持开源人工智能的人士纷纷转发。

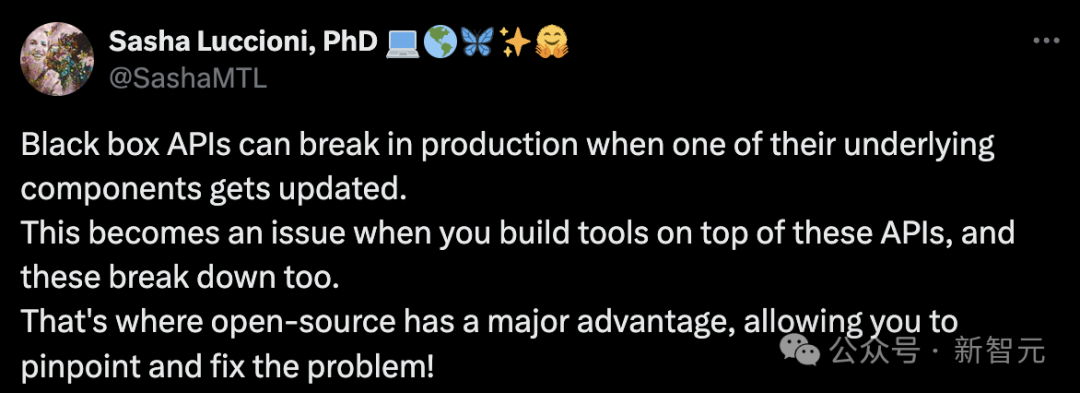

Hugging Face的AI研究员Dr. Sasha Luccioni表示,「当黑盒API的底层组件更新时,它们可能会在输出中崩溃。当你在这些API之上构建工具时,这就会成为一个问题,而这些API也会崩溃。这正是开源技术的一大优势,它可以让您准确定位并解决问题」!

发表评论 取消回复