语言是人类最重要的交流工具,也是人工智能领域最具挑战性的研究对象。如何让机器理解和生成自然语言,是人工智能的一个核心问题,也是人类智能的一个重要标志。近年来随着深度学习的发展,语言模型(Language Model,LM)作为一种基于神经网络的自然语言处理技术,取得了令人瞩目的成果。

语言模型的发展经历了从统计模型到神经网络模型的转变,其中最具代表性的是基于 Transformer 的大规模预训练语言模型(Large-scale Pre-trained Language Model,LLM)。Transformer 是一种基于自注意力机制(Self-Attention Mechanism)的神经网络架构,它可以有效地处理长距离的依赖关系,提高模型的并行性和效率。基于 Transformer 的 LLM 通过在大量的无标注文本上进行预训练,学习到了丰富的语言知识和语义表示,然后通过在特定的下游任务上进行微调,实现了对不同领域和场景的适应。基于 Transformer 的 LLM 的典型代表有 BERT、GPT、XLNet、T5 等,它们在各种自然语言处理任务上都取得了显著的性能提升,引领了自然语言处理的新浪潮。

基于 Transformer 的 LLM 也存在一些挑战和局限性,主要有以下几个方面:

1)模型规模的增长带来了计算资源和存储空间的巨大需求。为了提高模型的表达能力和泛化能力,基于 Transformer 的 LLM 不断增加模型的参数数量和层数,从几百万到几十亿,甚至到几万亿。这导致了模型的训练和推理需要大量的计算资源和存储空间,增加了模型的部署和使用的成本和难度。

2)模型的预训练和微调过程缺乏有效的指导和反馈。基于 Transformer 的 LLM 通常使用无监督的目标函数,如掩码语言模型(Masked Language Model,MLM)或自回归语言模型(Autoregressive Language Model,ARLM),来进行预训练,这些目标函数只利用了文本的局部信息,忽略了文本的整体结构和语义。而在微调过程中,模型只能根据下游任务的标签进行调整,缺乏对模型输出的有效指导和反馈,导致模型的输出可能不符合用户的期望和需求。

3)模型的泛化能力和适应能力有待提高。基于 Transformer 的 LLM 虽然在预训练阶段学习到了大量的语言知识,但是在面对不同的下游任务和领域时,仍然需要进行大量的微调,才能达到较好的性能。这意味着模型的泛化能力和适应能力有限,不能很好地处理新的或复杂的语言现象和场景。

图片

图片

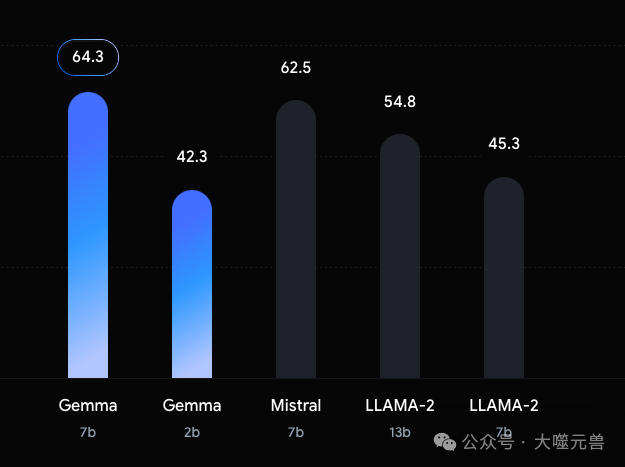

为了解决这些问题,Google 最近发布了一系列新的开源模型:Gemma,它们是基于用于创建 Google Gemini 模型的研究和技术构建的轻量级模型。Gemma 模型包括 2B 和 7B 两种规模,分别有 20 亿和 70 亿个参数,可以用于各种自然语言处理任务,如文本生成、问答、对话和情感分析。Gemma 模型使用了一种称为低秩适应(LoRA)的技术,可以在保持模型输出质量的同时,大大减少微调所需的参数数量和训练时间。Gemma 模型还使用了一种称为指令调优(Instruction Tuning,IT)的技术,可以通过用户提供的指令来控制模型的行为和输出,实现更灵活和可定制的文本生成。Gemma 模型由 Kaggle 托管,用户需要在 Kaggle 上请求访问权限,并接受相关条款和条件。用户还可以使用不同的后端和框架,如 JAX、Keras、PyTorch 和 Transformers 来访问和使用 Gemma 模型。

Gartner 分析师 Chirag Dekate 表示,谷歌的新模型表明 2024 年是小语言模型(SLM) 和大语言模型的一年。

“在 GenAI 时代,企业不仅需要能够从 LLM 创造价值,还需要能够以较低的价格从 SLM 中创造价值,这些价值对他们来说很重要,而且可以在其数据环境中进行情境化,这变得非常重要,”德卡特说道。

Constellation Research 创始人 R.“Ray”Wang 表示,较小的语言模型使企业能够获得更高的精度。

01 Gemma 模型的背景

Gemma 模型的背景可以追溯到 Google Gemini 模型的研究和开发。Gemini 是 Google 在 2020 年底发布的一种新型的大规模预训练语言模型,它具有 1012 亿个参数,是当时世界上最大的语言模型。Gemini 模型的目标是实现一种通用的语言理解和生成的能力,可以用于各种自然语言处理的任务和场景,如对话、摘要、翻译、问答等。Gemini 模型的特点是使用了一种称为 Switch Transformer 的新型神经网络架构,它可以动态地调整模型的大小和复杂度,以适应不同的输入和输出,从而提高模型的效率和灵活性。Gemini 模型还使用了一种称为 Mixture of Experts(MoE)的技术,它可以将模型的参数分布在多个专家模块中,从而提高模型的容量和表达能力。

Gemini 模型的研究和开发为 Google 带来了许多新的技术和经验,也为 Google 的其他产品和服务提供了支持和帮助。例如,Google Assistant 使用了 Gemini 模型的一部分来提升其对话和问答的能力,Google Translate 使用了 Gemini 模型的一部分来提升其翻译的质量和速度,Google Search 使用了 Gemini 模型的一部分来提升其搜索的相关性和准确性等。然而,Gemini 模型的规模和复杂度也给 Google 带来了一些挑战和困难,主要有以下几个方面:

Gemini 模型的训练和推理需要大量的计算资源和存储空间,超出了大多数用户和开发者的可用范围。Gemini 模型的训练需要使用数千个 TPU 芯片,耗时数周,而推理需要使用数百个 TPU 芯片,耗时数秒。这意味着 Gemini 模型的使用和部署需要高昂的成本和复杂的技术,不适合普通的个人和企业。

Gemini 模型的预训练和微调过程缺乏有效的指导和反馈,导致模型的输出可能不符合用户的期望和需求。Gemini 模型在预训练阶段使用了无监督的目标函数,如 MLM 或 ARLM,这些目标函数只利用了文本的局部信息,忽略了文本的整体结构和语义。而在微调过程中,模型只能根据下游任务的标签进行调整,缺乏对模型输出的有效指导和反馈。这导致模型的输出可能不符合用户的期望和需求,例如,模型可能生成不相关或不合理的文本,或者模型可能无法处理一些特定的指令或场景。

Gemini 模型的泛化能力和适应能力有待提高,不能很好地处理新的或复杂的语言现象和场景。Gemini 模型虽然在预训练阶段学习到了大量的语言知识,但是在面对不同的下游任务和领域时,仍然需要进行大量的微调,才能达到较好的性能。这意味着模型的泛化能力和适应能力有限,不能很好地处理新的或复杂的语言现象和场景,例如,模型可能无法理解一些特殊的术语或缩写,或者模型可能无法生成一些特定的文本类型或风格。

为了解决这些问题,Google 基于 Gemini 模型的研究和技术开发了一系列新的开放模型:Gemma,它们是一种轻量级而灵活的语言模型,可以用于各种自然语言处理任务,如文本生成、问答、对话和情感分析。

Gemma 模型的创新点主要有以下几个方面:

Gemma 模型使用一种称为低秩适应(LoRA)的技术,可以在保持模型输出质量的同时,大大减少微调所需的参数数量和训练时间。LoRA 是一种基于低秩矩阵分解的技术,它可以将模型的权重矩阵分解为两个较小的矩阵的乘积,从而降低模型的复杂度和冗余度。LoRA 可以动态地调整模型的大小和复杂度,以适应不同的任务和场景,从而提高模型的效率和灵活性。Gemma 模型使用了 LoRA 的两种变体:LoRA-IT 和 LoRA-PT,分别用于指令调优和预训练。LoRA-IT 可以将模型的参数数量减少 99.9%,而 LoRA-PT 可以将模型的参数数量减少 99.5%。

Gemma 模型使用一种称为指令调优(IT)的技术,可以通过用户提供的指令来控制模型的行为和输出,实现更灵活和可定制的文本生成。指令是一种用于描述用户期望和需求的自然语言表达,它可以指定模型的目标、约束、风格等。指令调优是一种基于指令的微调方法,它可以在训练和推理时使用指令来引导模型的学习和生成,从而提高模型的质量和多样性。Gemma 模型使用了一种特殊的标记系统,称为 Gemma 格式,来表示对话中的角色、轮次和指令,从而实现对模型的有效控制。

Gemma 模型使用一种称为 Switch Transformer 的新型神经网络架构,它可以动态地调整模型的大小和复杂度,以适应不同的输入和输出,从而提高模型的效率和灵活性。Switch Transformer 是一种基于 Transformer 的架构,它使用了一种称为 Mixture of Experts(MoE)的技术,它可以将模型的参数分布在多个专家模块中,从而提高模型的容量和表达能力。Switch Transformer 还使用了一种称为路由器(Router)的技术,它可以根据输入的特征,动态地选择合适的专家模块,从而减少模型的计算开销和存储需求。

图片

图片

图1:与 Llama 2 和 Mistral 7B 等热门模型相比,Gemma 在尺寸方面的优越性能设定了新标准

02 Gemma 模型的原理

Gemma 模型的原理主要涉及到三个方面:低秩适应、指令调优和 Switch Transformer。下面我们分别介绍这三个方面的原理和细节。

低秩适应

低秩适应(LoRA)是一种基于低秩矩阵分解的技术,它可以将模型的权重矩阵分解为两个较小的矩阵的乘积,从而降低模型的复杂度和冗余度。低秩适应的基本思想是,模型的权重矩阵可以近似地表示为一个低秩的矩阵,即一个秩(Rank)远小于矩阵维度的矩阵。低秩矩阵可以通过两个较小的矩阵的乘积来表示,例如,一个 m x n 的矩阵 W 可以表示为一个 m x r 的矩阵 U 和一个 r x n 的矩阵 V 的乘积,即 W = UV,其中 r 是一个小于 m 和 n 的正整数,称为矩阵的秩。这样,我们就可以用 2mr 个参数来代替 mn 个参数,从而减少模型的参数数量和存储空间。同时,低秩矩阵也可以减少模型的冗余度和噪声,从而提高模型的泛化能力和稳定性。

低秩适应的一个关键问题是如何确定矩阵的秩,即 r 的值。如果 r 太小,那么低秩矩阵可能无法很好地近似原始矩阵,导致模型的性能下降;如果 r 太大,那么低秩矩阵可能无法很好地压缩原始矩阵,导致模型的效率降低。因此,我们需要根据不同的任务和场景,动态地调整 r 的值,以达到最佳的平衡。Gemma 模型使用了一种称为自适应秩(Adaptive Rank)的技术,它可以根据输入的特征和输出的目标,自动地选择合适的 r 的值,从而实现模型的动态调整。具体来说,Gemma 模型使用了一种称为自适应秩(Adaptive Rank)的技术,它可以根据输入的特征和输出的目标,自动地选择合适的 r 的值,从而实现模型的动态调整。具体来说,Gemma 模型使用了一个额外的神经网络,称为秩预测器(Rank Predictor),它可以根据输入的特征,如词频、词性、词义等,预测每个权重矩阵的最佳 r 的值,然后将这些值作为低秩矩阵分解的参数,从而得到低秩的权重矩阵。这样,Gemma 模型可以根据不同的任务和场景,动态地调整模型的大小和复杂度,以达到最佳的平衡。

Gemma 模型使用了两种不同的低秩适应的变体,分别用于指令调优和预训练,分别称为 LoRA-IT 和 LoRA-PT。LoRA-IT 是一种用于指令调优的低秩适应方法,它可以将模型的参数数量减少 99.9%,从 20 亿或 70 亿减少到 130 万或 450 万。LoRA-IT 的主要思想是,将模型的权重矩阵分解为两个部分:一个固定的原始权重矩阵,和一个可训练的低秩矩阵,然后将这两个部分相加,得到最终的权重矩阵。这样,模型可以保留原始权重矩阵的信息,同时通过低秩矩阵进行微调,以适应不同的指令。LoRA-PT 是一种用于预训练的低秩适应方法,它可以将模型的参数数量减少 99.5%,从 20 亿或 70 亿减少到 1 亿或 3.5 亿。LoRA-PT 的主要思想是,将模型的权重矩阵分解为两个部分:一个固定的低秩矩阵,和一个可训练的残差矩阵,然后将这两个部分相加,得到最终的权重矩阵。这样,模型可以利用低秩矩阵进行预训练,同时通过残差矩阵进行微调,以适应不同的任务。

指令调优

指令调优(IT)是一种基于指令的微调方法,它可以通过用户提供的指令来控制模型的行为和输出,实现更灵活和可定制的文本生成。指令是一种用于描述用户期望和需求的自然语言表达,它可以指定模型的目标、约束、风格等。例如,用户可以提供以下几种类型的指令:

- 任务指令,用于指定模型要完成的任务,如“写一首诗”、“回答这个问题”、“写一篇文章”等。

- 内容指令,用于指定模型要生成的内容,如“关于春天的”、“包含这些关键词的”、“基于这个故事的”等。

- 风格指令,用于指定模型要生成的风格,如“幽默的”、“正式的”、“押韵的”等。

- 约束指令,用于指定模型要遵守的约束,如“不超过 100 个词”、“不包含敏感词”、“不抄袭”等。

指令调优的主要思想是,将用户提供的指令作为模型的输入的一部分,从而引导模型的学习和生成,使模型的输出符合用户的期望和需求。指令调优的过程分为两个阶段:训练阶段和推理阶段。在训练阶段,模型使用一些带有指令和标签的样本进行微调,学习如何根据不同的指令生成不同的文本。在推理阶段,模型根据用户提供的指令和输入,生成相应的文本。为了实现指令调优,Gemma 模型使用了一种特殊的标记系统,称为 Gemma 格式,来表示对话中的角色、轮次和指令。Gemma 格式使用四种特殊的控制令牌:<start_of_turn>、<end_of_turn>、user 和 model,以及一些可选的辅助令牌,如 <start_of_response> 和 <end_of_response>。Gemma 格式的示例是:

<start_of_turn>user Write a poem about spring<end_of_turn> <start_of_turn>model Spring is here, the flowers bloom The birds sing, the bees zoom The sun shines, the sky is blue Spring is here, and so are you<end_of_turn>

Switch Transformer

Switch Transformer 是一种基于 Transformer 的新型神经网络架构,它可以动态地调整模型的大小和复杂度,以适应不同的输入和输出,从而提高模型的效率和灵活性。Switch Transformer 的主要特点是使用了一种称为 Mixture of Experts(MoE)的技术,它可以将模型的参数分布在多个专家模块中,从而提高模型的容量和表达能力。MoE 是一种基于集成学习的技术,它可以将多个不同的模型组合在一起,形成一个更强大的模型。MoE 的基本思想是,不同的模型可以专注于不同的子任务或子领域,从而提高模型的专业性和多样性。MoE 的一个关键问题是如何将输入分配给不同的模型,即如何选择合适的专家。Switch Transformer 使用了一种称为路由器(Router)的技术,它可以根据输入的特征,动态地选择合适的专家模块,从而减少模型的计算开销和存储需求。路由器是一个额外的神经网络,它可以根据输入的特征,如词频、词性、词义等,预测每个专家模块的权重,然后根据这些权重,将输入分配给一个或多个专家模块,从而得到最终的输出。

Switch Transformer 的一个优点是,它可以动态地调整模型的大小和复杂度,以适应不同的输入和输出,从而提高模型的效率和灵活性。例如,对于一些简单的输入,如常见的词或短语,Switch Transformer 可以只使用少数的专家模块,从而节省计算资源和时间;而对于一些复杂的输入,如罕见的词或长句,Switch Transformer 可以使用更多的专家模块,从而提高模型的表达能力和质量。Switch Transformer 的另一个优点是,它可以提高模型的容量和表达能力,从而提高模型的泛化能力和适应能力。例如,对于一些新的或复杂的语言现象和场景,Switch Transformer 可以利用不同的专家模块,从而提高模型的专业性和多样性。

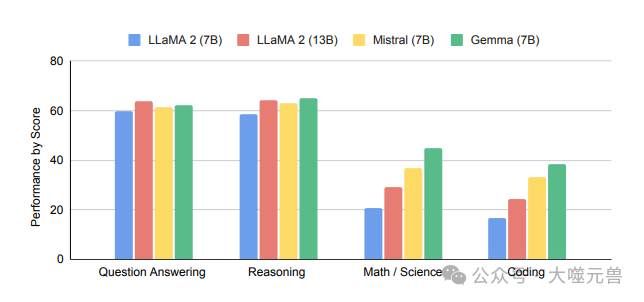

图2:与类似大小的开放模型相比,Gemma 7B在不同功能下的语言理解和生成性能。我们将标准的学术基准评估按能力分组,并对各自的得分进行平均;(详见技术文档表6)

03 Gemma 模型的应用和展望

Gemma 模型是一种强大而灵活的语言模型,可以用于各种自然语言处理任务,如文本生成、问答、对话和情感分析。

文本生成

文本生成是指根据一定的输入,自动地生成连贯的文本的任务,它可以用于各种场景,如创作、教育、娱乐、商业等。Gemma 模型可以根据用户提供的指令和输入,生成不同的文本类型和风格,如诗歌、故事、代码、文章、歌词等。Gemma 模型的优势是,它可以通过指令调优,实现对文本生成的灵活和可定制的控制,从而满足用户的不同期望和需求。例如,用户可以指定文本的主题、内容、长度、风格、约束等,从而得到更符合自己的意愿的文本。Gemma 模型的另一个优势是,它可以通过低秩适应,实现对文本生成的高效和快速的微调,从而适应不同的任务和场景。例如,用户可以在不同的平台和框架上,使用不同的后端和设备,快速地访问和使用 Gemma 模型,从而提高文本生成的效率和便利性。

问答

问答是指根据用户提出的问题,自动地给出相关的答案的任务,它可以用于各种领域,如科学、历史、文化、生活等。Gemma 模型可以根据用户提出的问题,生成简洁而准确的答案,或者提供相关的信息和资源,以帮助用户解决问题。Gemma 模型的优势是,它可以利用预训练阶段学习到的大量的语言知识和语义表示,从而提高问答的质量和准确性。例如,Gemma 模型可以理解不同的问题类型和难度,从而给出不同的答案格式和详细程度。Gemma 模型的另一个优势是,它可以利用指令调优,实现对问答的灵活和可定制的控制,从而满足用户的不同期望和需求。例如,用户可以指定问题的领域、范围、来源、语言等,从而得到更符合自己的意愿的答案。

对话

对话是指根据用户和模型之间的交互,自动地生成连贯的对话的任务,它可以用于各种目的,如咨询、娱乐、教育、社交等。Gemma 模型可以根据用户和模型之间的交互,生成自然而有趣的对话,或者提供相关的服务和建议,以增强用户的体验和满意度。Gemma 模型的优势是,它可以利用预训练阶段学习到的大量的语言知识和语义表示,从而提高对话的质量和流畅性。例如,Gemma 模型可以理解不同的对话类型和场景,从而给出不同的对话策略和风格。Gemma 模型的另一个优势是,它可以利用指令调优,实现对对话的灵活和可定制的控制,从而满足用户的不同期望和需求。例如,用户可以指定对话的目的、主题、角色、情感等,从而得到更符合自己的意愿的对话。

情感分析

情感分析是指根据用户提供的文本,自动地判断文本的情感倾向和强度的任务,它可以用于各种应用,如评论、反馈、舆情、推荐等。Gemma 模型可以根据用户提供的文本,生成简洁而准确的情感分析结果,或者提供相关的建议和反馈,以帮助用户了解和改善自己的情感状态。Gemma 模型的优势是,它可以利用预训练阶段学习到的大量的语言知识和语义表示,从而提高情感分析的质量和准确性。例如,Gemma 模型可以理解不同的文本类型和风格,从而给出不同的情感标签和分数。Gemma 模型的另一个优势是,它可以利用指令调优,实现对情感分析的灵活和可定制的控制,从而满足用户的不同期望和需求。例如,用户可以指定文本的领域、范围、来源、语言等,从而得到更符合自己的意愿的情感分析结果。

Gemma 模型是一种强大而灵活的语言模型,它可以用于各种自然语言处理任务,如文本生成、问答、对话和情感分析。Gemma 模型的创新点主要有以下几个方面:低秩适应、指令调优和 Switch Transformer。低秩适应是一种基于低秩矩阵分解的技术,它可以在保持模型输出质量的同时,大大减少微调所需的参数数量和训练时间。指令调优是一种基于指令的微调方法,它可以通过用户提供的指令来控制模型的行为和输出,实现更灵活和可定制的文本生成。Switch Transformer 是一种基于 Transformer 的新型神经网络架构,它可以动态地调整模型的大小和复杂度,以适应不同的输入和输出,从而提高模型的效率和灵活性。Gemma 模型的原理主要涉及到三个方面:低秩适应、指令调优和 Switch Transformer。低秩适应的基本思想是,将模型的权重矩阵分解为两个较小的矩阵的乘积,从而降低模型的复杂度和冗余度。指令调优的主要思想是,将用户提供的指令作为模型的输入的一部分,从而引导模型的学习和生成,使模型的输出符合用户的期望和需求。Switch Transformer 的主要特点是使用了一种称为 Mixture of Experts(MoE)的技术,它可以将模型的参数分布在多个专家模块中,从而提高模型的容量和表达能力。Gemma 模型的应用和展望主要有以下几个方面:文本生成、问答、对话和情感分析。文本生成是指根据一定的输入,自动地生成连贯的文本的任务,它可以用于各种场景,如创作、教育、娱乐、商业等。问答是指根据用户提出的问题,自动地给出相关的答案的任务,它可以用于各种领域,如科学、历史、文化、生活等。对话是指根据用户和模型之间的交互,自动地生成连贯的对话的任务,它可以用于各种目的,如咨询、娱乐、教育、社交等。Gemma 模型可以根据用户和模型之间的交互,生成自然而有趣的对话,或者提供相关的服务和建议,以增强用户的体验和满意度。情感分析是指根据用户提供的文本,自动地判断文本的情感倾向和强度的任务,它可以用于各种应用,如评论、反馈、舆情、推荐等。Gemma 模型可以根据用户提供的文本,生成简洁而准确的情感分析结果,或者提供相关的建议和反馈,以帮助用户了解和改善自己的情感状态。

Gemma 模型是一种强大而灵活的语言模型,它可以用于各种自然语言处理任务,如文本生成、问答、对话和情感分析。Gemma 模型的创新点、原理、应用和展望,都体现了 Google 在人工智能领域的最新进展和创新,也为用户和开发者提供了更多的选择和机会。Gemma 模型的优势在于,它可以通过低秩适应、指令调优和 Switch Transformer,实现对模型的动态调整、灵活控制和高效运行,从而提高模型的性能和质量,满足用户的不同期望和需求。Gemma 模型的挑战在于,它需要在保证模型的通用性和泛化能力的同时,适应不同的任务和场景,处理不同的语言现象和场景,从而提高模型的专业性和多样性。Gemma 模型的前景在于,它可以通过不断的研究和开发,优化模型的架构和技术,扩展模型的应用和领域,从而提高模型的影响力和价值。

总之,Gemma 模型是一种强大而灵活的语言模型,它可以用于各种自然语言处理任务,如文本生成、问答、对话和情感分析。Gemma 模型的创新点、原理、应用和展望,都值得我们深入了解和使用。Gemma 模型不仅是 Google 在人工智能领域的一项重要贡献,也是我们在语言理解和生成方面的一次重要探索。(END)

参考资料:

1.https://ai.google.dev/gemma/docs

2.https://storage.googleapis.com/deepmind-media/gemma/gemma-report.pdf

发表评论 取消回复